Google 揭晓自家超级 AI 电脑性能优于 Nvidia

Google 4 日发表论文,公开自家超级 AI 电脑的详细信息,其性能优于用于训练 OpenAI 的 ChatGPT 超级计算机

Nvidia 在 AI 模型训练和产品部署具有主导地位,市占超过90%,目前最受瞩目的 AI 模型及其产品即是 OpenAI 的 ChatGPT。

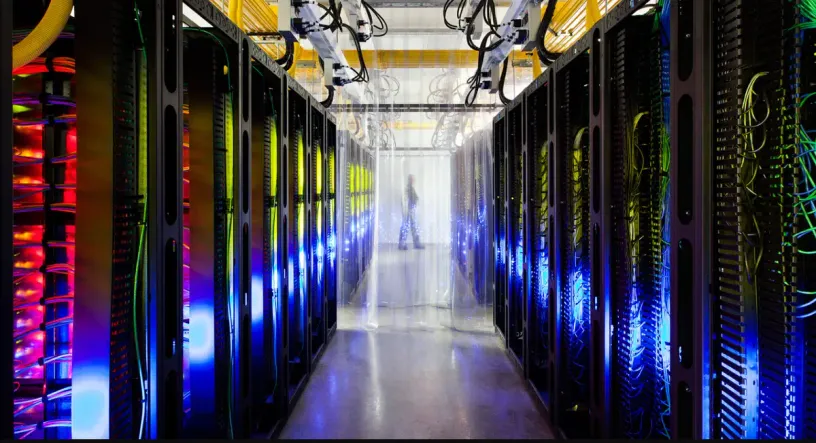

结合大量电脑设备和数千个 Nvidia A100 芯片来训练模型。而自 2016 年以来,Google 一直在设计和部署称为 Tensor Processing Units(TPU)的自研 AI 芯片,现在有进一步的成果。

Google 4 日发表论文,公开其中一部 AI 超级电脑的详细信息,声称比竞争对手Nvidia 的系统运算更快、功耗更低。

Google 已经建构一套系统,其中包含超过 4,000 个 TPU,并结合执行和训练 AI 模型的自定义零件,这部以 TPU 为基础的 AI 超级电脑称为 TPU v4。它从 2020 年开始运作,用于训练自家 PaLM 模型超过 50 天。

在效能、可扩展性、可用性上 TPU v4 成为大型语言模型的主力,Google 研究人员表示,TPU v4 能比 Nvidia A100 组成类似大小的系统,运算快1.2~1.7 倍,功耗低1.3~1.9 倍。

不过,Google 的 TPU 并未与 Nvidia 最新 AI 芯片 H100 进行比较,因为后者推出不久,且采用更先进的制程。

另一方面,由学术界和产业人士组成的人工智慧领袖联盟制定出 MLPerf 基准,在 5 日公布全产业 AI 芯片测试结果和排名。对此 Nvidia 执行长黄仁勋表示,Nvidia H100 的测试结果明显优于上一代。

今日 MLPerf 3.0 突显出以 Hopper 架构为基础的 H100,其效能是 A100 的 4 倍,黄仁勋在官方部落格写道,并认为下一阶段的AI(Generative AI)需要新的基础设施,以训练高性能的大型语言模型。

AI 所需的大量算力是相当昂贵的,于是 Nvidia、Google 等产业人士大多专注于开发新的芯片、光学连接零件等,或从软体技术方面着手,减少大量运算所需的功耗。

Google 被认为是 AI 领域的主要先驱,旗下研究人员在过去 10 年已经取得重要进展。然而随着 OpenAI 推出 ChatGPT,引爆人工智能热潮。

部分人士认为 Google AI 技术商业化方面明显落后,这也迫使 Google 现在竞相发表产品并试图证明没有挥霍领先优势。